C’est un événement que j’attends toujours avec grand intérêt, particulièrement depuis trois ans où Google conçoit ses propres produits et se démarque par ses avancées dans le domaine de l’intelligence artificielle. D’ailleurs, elle est encore une fois au cœur de la plupart des annonces de cette conférence I/O 2019. Elles étaient si nombreuses et intéressantes que j’ai décidé de rédiger deux articles à ce sujet pour que ce soit plus facile à lire. Cette première partie est donc axée sur les annonces liées à l’intelligence artificielle (moteur de recherche, Google Lens, Google Maps et plus).

C’était plutôt une bonne conférence avec de nombreuses nouveautés qui touchent plusieurs services et produits de Google. Je les aborde dans l’ordre où elles ont été présentées lors de la conférence.

De la réalité augmentée et de la 3D dans le moteur de recherche

Parlons de « réalité augmentée », cette technologie qui projette dans le monde réel des éléments du monde virtuel. Pour beaucoup de gens, elle est encore un terme plutôt technique et souvent mal compris. Mais avec ce qui s’en vient sur le moteur de recherche de Google, ces gens (peut-être vous ?) commenceront peut-être à réellement voir son intérêt et à utiliser la technologie.

Voilà près de 17 ans que l’on fait des recherches sur l’outil de Google et 2019 va marquer une étape importante dans son histoire. Dès ce mois-ci, on verra apparaître dans les résultats de recherche des « objets 3D » avec la possibilité de les utiliser en réalité augmentée avec son téléphone.

Par exemple, vous pourriez chercher et trouver une paire de chaussures dans l’outil de recherche de Google sur votre téléphone intelligent, appuyer sur l’item qui vous plait et le voir apparaître sur votre lit à côté de vos vêtements en pointant la caméra de l’appareil vers ceux-ci. Lors de sa conférence, Google a aussi fait la démonstration d’une recherche sur l’anatomie du corps humain et le résultat où l’on voit un squelette prendre place sur un vrai bureau. Cette vidéo vous aidera à comprendre.

NOTE | En cliquant sur l'image, vous consentez à ce que certaines données de suivi soient recueillies par Google.

Le moteur de recherche de Google va également bientôt indexer et afficher directement dans ses résultats les podcasts en analysant leur contenu. Il sera notamment possible de lire un podcast par un simple bouton ou l’ajouter à une liste à regarder plus tard. À ce sujet, aviez-vous déjà consulté mon guide des podcasts techno / geeks québécois ?

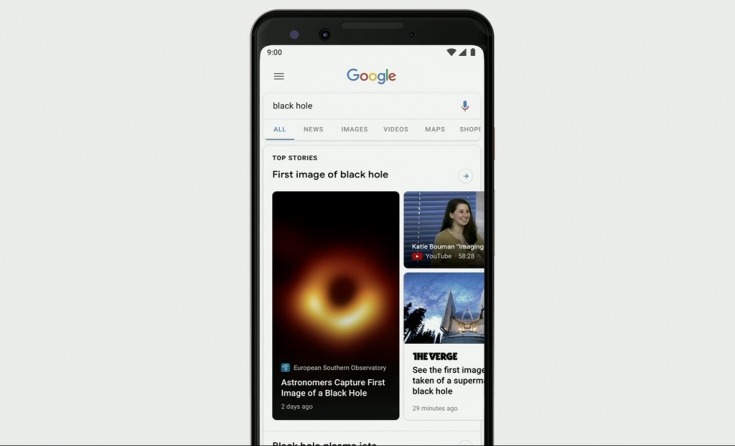

Enfin, l’outil de recherche affichera en haut de ses résultats les « Top Stories », des actualités liées au terme recherché et triées par l’intelligence artificielle. Un lien donnera accès à la « Couverture complète » du sujet, fonctionnalité introduite dans Google Actualités l’an dernier (j’en parlais dans mon article consacré à la conférence Google I/O 2018). D’ailleurs, quelques améliorations et retouches ont été apportées à Google Actualités qui proposera une « ligne de temps » (ou « Timeline ») affichant les articles de presse publiés tout au long de la journée selon un ordre chronologique. Tout cela sera offert plus tard cette année.

Des améliorations intéressantes dans Google Lens

Encore une fois, j’ai abordé le sujet de Google Lens dans mon article de l’an dernier lié à la conférence Google I/O 2018, je vous invite donc à le consulter. Cette fonctionnalité utilise l’intelligence artificielle et la reconnaissance d’images pour fournir à l’utilisateur des informations relatives à un sujet photographié. Google Lens a encore été amélioré.

Durant la conférence, un exemple a été démontré avec le menu d’un restaurant qui, une fois pointé par la caméra du téléphone, met en surbrillance à l’écran les plats les plus populaires et les plus appréciés des clients. Une pression du doigt sur l’un de ces plats affiche des photos de celui-ci qui sont issues de Google Maps. Plus encore, en pointant le téléphone vers la facture à la fin du repas, Google Lens peut calculer le pourboire et diviser le montant total pour connaître la part de chaque parent ou ami.

Google Lens peut aussi maintenant lire à voix haute du texte pointé par la caméra du téléphone et le traduire en temps réel à l’écran, sous forme écrite ou vocale. Douze langues sont déjà supportées, dont le français.

NOTE | En cliquant sur l'image, vous consentez à ce que certaines données de suivi soient recueillies par Google.

Google Assistant encore plus intelligent, mais aussi véritablement plus rapide

D’abord, l’an dernier Google avait présenté « Duplex », une fonctionnalité de son assistant qui peut avoir littéralement une conversation téléphonique à votre place. L’assistant peut alors, par exemple, commander à votre place et de façon très naturelle un repas dans un restaurant.

Google va plus loin avec son idée et portera la technologie jusque sur le Web. La fonctionnalité est baptisée « Duplex on the Web ». Grâce à elle, Google Assistant pourra effectuer certaines tâches en ligne comme, par exemple, la réservation d’un voyage ou des places de spectacle en remplissant les formulaires à votre place. Intéressant, mais ce sera offert plus tard cette année et seulement aux États-Unis pour commencer (déjà que peu d’utilisateurs ont eu accès à Duplex dévoilé l’an dernier… !).

NOTE | En cliquant sur l'image, vous consentez à ce que certaines données de suivi soient recueillies par Google.

L’assistant devient rapide comme l’éclair

Par ailleurs, Google a apporté des améliorations notables à son assistant intelligent, particulièrement en termes de rapidité. La société a réussi à réduire considérablement la quantité de données nécessaires au traitement des opérations effectuées par son assistant. Si bien que le traitement pourra maintenant être effectué directement sur le téléphone plutôt que par l’intermédiaire des serveurs de Google.

Grâce à cette prouesse, l’assistant propose enfin la conversation continue et peut répondre rapidement à un enchaînement de commandes sans que l’on ait à dire « OK Google » à chaque fois.

Mieux encore, il peut effectuer plusieurs actions simultanément en utilisant diverses applications pour accomplir une tâche, et ce, sans devoir passer d’une application à l’autre. Il pourra par exemple composer un courriel à votre demande et insérer une image provenant de l’application Google Photos avant de procéder à l’envoi du message. Le tout, sans aucune latence. C’est tout simplement génial, du moins pour les utilisateurs d’un téléphone Pixel comme moi qui pourront en profiter avant tout le monde plus tard cette année.

NOTE | En cliquant sur l'image, vous consentez à ce que certaines données de suivi soient recueillies par Google.

Nos données personnelles, elles servent aussi à cela…

Évidemment, quand on parle de Google et de l’intelligence artificielle, on pense inévitablement à la collecte de nos données et à la vie privée. Pour ma part, j’ai toujours dit que je préférais fournir mes données à Google plutôt qu’à un réseau comme Facebook. C’est simplement que j’ai l’impression que cela sert au moins à quelque chose et pas seulement à la publicité ciblée. Ne me jugez pas, même si c’est facile de le faire… Je suis peut-être inconscient de la réalité ou simplement moins paranoïaque que la moyenne des gens.

Mon opinion s’appuie encore une fois sur les innovations présentées cette semaine pour Google Assistant. Il peut maintenant comprendre le contexte de certaines phrases grâce à des références personnelles. En d’autres termes, Google Assistant va utiliser tout ce qu’il sait de vos habitudes pour mieux vous comprendre et répondre à vos requêtes. Vous pourrez par exemple lui demander de vous montrer les photos de votre enfant et il saura lesquelles vous afficher. Oui ça fait peur, mais c’est aussi utile. Non ?

Mais Google pense aussi à votre vie privée

Bon, rassurez-vous, après toutes ces annonces sur l’intelligence artificielle de plus en plus sophistiquée, Google a dévoilé quelques améliorations importantes dans la gestion de nos données personnelles.

Ainsi, un grand nombre des services de Google proposeront bientôt un accès simplifié et plus rapide à la gestion de son compte Google et des informations collectées par ses services. Une nouvelle option intéressante fera aussi son apparition dans quelques semaines. Elle permettra à l’utilisateur de supprimer automatiquement de son compte après 3 mois ou 18 mois plusieurs données personnelles collectées par Google.

On peut toujours désactiver les types de données collectées par Google et supprimer manuellement celles-ci en accédant à son compte sur cette page : https://myaccount.google.com/activitycontrols.

Enfin, Google a annoncé un mode incognito qui, comme dans Google Chrome, permettra d’utiliser YouTube et Google Maps sans qu’ils ne conservent les traces de notre activité.

Et quoi d’autre pour finir cet article ?

C’est presque terminé, promis ! Mais puisque je parlais de Google Maps dans le dernier paragraphe, j’ajoute que l’application va intégrer un nouveau mode de conduite (Driving Mode). Son interface sera organisée de façon à optimiser l’utilisation de l’application tout en réduisant au maximum les distractions sur la route. On pourra notamment accepter ou refuser un appel par la voix sans toucher au téléphone. Ce sera offert dès cet été pour la plupart des téléphones qui ont l’application Google Assistant (donc pas seulement les Pixel).

Pour finir, un petit mot sur deux fonctionnalités destinées aux personnes ayant des problèmes de langage et d’audition. D’abord, « Live Caption » va retranscrire à l’écran et en temps réel l’audio d’une vidéo ou d’un podcast joué sur le téléphone. Le tout fonctionne entièrement en « local » sur l’appareil, donc sans connexion Internet.

Ensuite, « Live Relay » utilise le même principe de reconnaissance vocale, mais pour les appels vocaux. La fonction retranscrit sous forme de texte sur le téléphone ce qui est prononcé par l’interlocuteur. Ce dernier reçoit alors une réponse vocale de l’assistant Google qui ne fait que dicter ce que la personne appelée écrit à son tour.

NOTE | En cliquant sur l'image, vous consentez à ce que certaines données de suivi soient recueillies par Google.

Malheureusement, ces deux fonctionnalités seront offertes seulement aux utilisateurs qui recevront la prochaine mise à jour d’Android (10) qui sortira à la fin de l’été. Vous retrouverez les détails sur l’annonce d’Android Q et des nouveaux produits de Google dans mon second article consacré à la conférence Google I/O 2019.